Accélération de l’intelligence artificielle

L’ANI, ou Artificial Narrow Intelligence

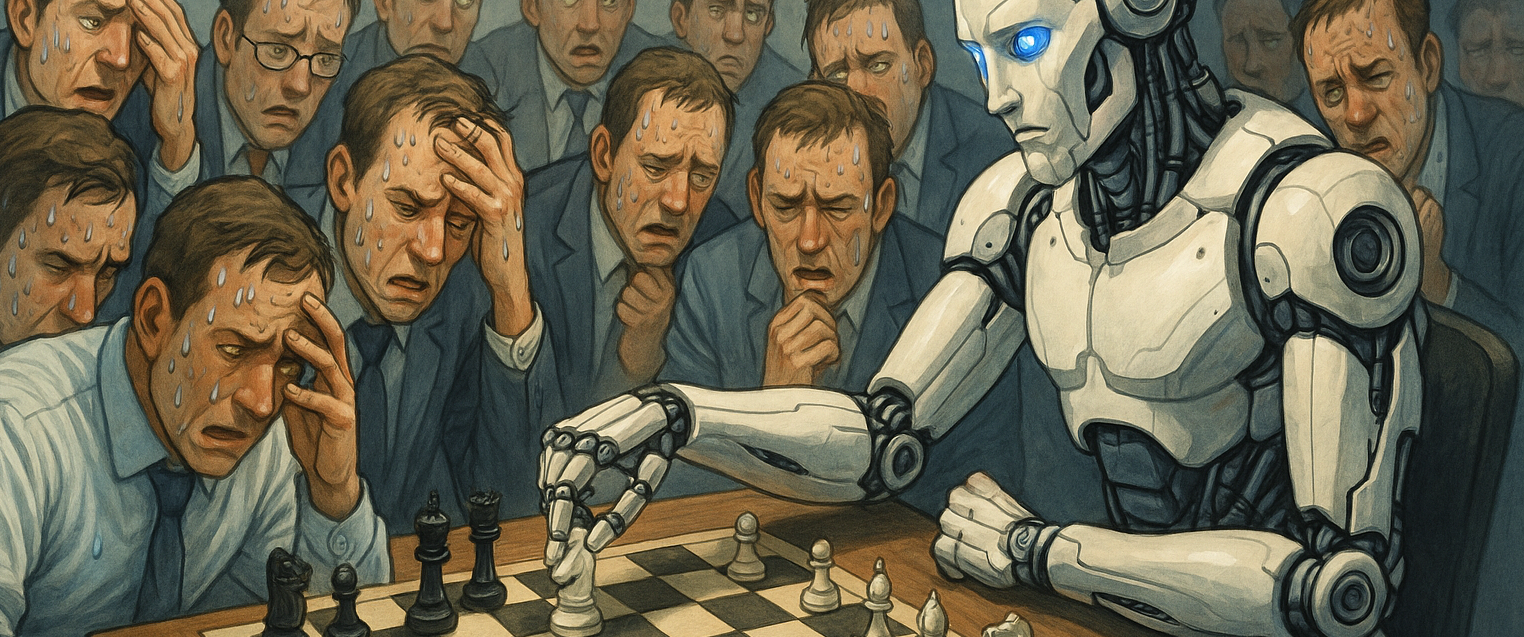

L’ANI, ou Artificial Narrow Intelligence, désigne la première phase stable de déploiement industriel de l’intelligence artificielle. Par définition, elle se limite à des tâches précises, répétitives ou calculatoires, sans conscience globale ni transversalité cognitive. Elle excelle dans des domaines restreints : traitement de données, reconnaissance d’images, traduction, génération de texte, recommandation algorithmique. Cette spécialisation n’est pas une faiblesse, mais au contraire la source de sa puissance, car elle permet une performance inégalée dans des fonctions ciblées.

La rupture par rapport aux générations précédentes — notamment les systèmes dits "experts" ou les assistants vocaux sans apprentissage profond — est décisive. Là où l’automatisation reposait auparavant sur des règles codées, l’ANI repose sur des modèles d’apprentissage statistique entraînés sur d’immenses jeux de données. Cette bascule a permis à des IA comme GPT, Claude, Mistral ou Gemini de dépasser les performances humaines sur certaines tâches bien délimitées, tout en restant fondamentalement non conscientes, incapables d’initiative autonome ou de généralisation hors contexte.

L’ANI ne présente pas de singularité en elle-même — au sens d’un point de bascule irréversible — mais elle constitue la seule phase réellement observable et largement exploitée à ce jour. Elle est déjà suffisamment puissante pour transformer les chaînes de valeur, les modèles économiques et les équilibres de pouvoir, sans franchir le seuil critique de l’AGI. Elle est omniprésente dans les copilotes (GitHub Copilot, ChatGPT, Claude, etc.), les systèmes de scoring (crédit, recrutement), les agents de relation client, les plateformes de logistique prédictive ou encore les IA embarquées dans les véhicules ou les drones civils.

Sur le plan géopolitique, l’ANI a déjà modifié les rapports de force entre nations. L’explosion des modèles fondationnels a provoqué une course à la puissance computationnelle (cf. l’essor de CoreWeave, Nvidia, et des fermes GPU mutualisées), dominée par les États-Unis et la Chine. L’Europe reste technologiquement dépendante, en particulier pour l’entraînement des modèles de grande taille, mais tente de compenser ce retard par une régulation pionnière (AI Act) et des initiatives telles que l’IA souveraine. L’ANI est aussi devenue un enjeu de sécurité nationale, comme en témoigne la pression exercée sur l’accès aux puces Nvidia H100 ou les restrictions à l’exportation de certains composants vers des puissances jugées concurrentes.

Les autres impacts sont déjà visibles : automatisation des métiers cognitifs, recomposition des emplois dans les services, transformation du rapport à l’information et à la vérité (phénomène des hallucinations IA), mais aussi génération de dépendances invisibles, où l’utilisateur ne perçoit plus la frontière entre assistance et délégation. L’usage massif d’outils génératifs brouille la chaîne de responsabilité, accroît la surface d’exposition cyber et soulève des incertitudes juridiques sur la propriété intellectuelle, la protection des données ou la loyauté des décisions automatisées.

La période d’exploitation de l’ANI peut raisonnablement être fixée entre 2020 et 2030. Elle est déjà en service, à large échelle, dans tous les secteurs. Le point d’inflexion s’est produit entre 2022 et 2023 avec la libération des modèles comme ChatGPT-3.5/4 et leur intégration native dans les écosystèmes de travail (Microsoft 365, Google Workspace, etc.). En 2025, l’ANI n’est plus un prototype mais une commodité, intégrée dans les chaînes de production, les outils bureautiques, les plateformes CRM ou les services RH. Son usage est quotidien mais souvent opaque pour l’utilisateur final.

Le positionnement UCN (Utilisation, Capacité, Niveau d’autonomie) est le suivant : forte Utilisation, capacité technique spécialisée mais haute, autonomie faible à modérée. Cela signifie que l’ANI libère un fort potentiel de productivité dans les contextes bien cadrés, mais qu’elle n’agit jamais hors cadre ni de manière imprévisible. Cela rassure, tout en créant une illusion de stabilité qui peut masquer les risques d’erreurs systémiques ou de dérives sous-jacentes.

Les publications solides qui fondent cette étape sont nombreuses. On peut citer notamment :

-

“Emergent Abilities of Large Language Models” (Wei et al., 2022) pour la compréhension des comportements inattendus dans les LLM.

-

“Attention is All You Need” (Vaswani et al., 2017) pour les fondations techniques de l’ANI actuelle.

-

OECD – AI Policy Observatory pour une analyse comparative de l’usage de l’IA selon les pays.

-

Federal Reserve Bank of St. Louis (2024) qui indique que 40 % des adultes américains utilisent déjà une IA générative dans leur quotidien.

La cible de population utilisatrice est très marquée : jeunes, actifs, diplômés, urbains, travaillant dans le tertiaire supérieur ou les fonctions technologiques. Cette segmentation engendre une fracture numérique profonde. En 2021, près d’un tiers de l’humanité n’avait pas accès à Internet. En 2025, moins de la moitié de la population mondiale aura accès à l’ANI dans des conditions de qualité suffisantes. Ce clivage n’est pas seulement technique : il devient social, culturel, économique et même géopolitique.

Les questions éthiques soulevées sont déjà critiques. Peut-on faire confiance à un modèle dont les biais sont hérités des données d’entraînement ? Qui est responsable lorsqu’une décision prise avec l’aide d’une IA nuit à une personne ? Comment garantir la transparence, la traçabilité, la non-discrimination algorithmique ? L’ANI nous place au seuil d’une nouvelle ingénierie du risque : les erreurs sont rares mais systémiques, difficilement détectables, et peuvent se propager à très grande échelle.

L’accessibilité de l’ANI est contrastée. Les plateformes grand public sont gratuites ou peu coûteuses, mais la vraie puissance — les modèles spécialisés, les API haut de gamme, les services personnalisés — reste réservée aux entreprises ou aux gouvernements dotés de ressources suffisantes. Cette asymétrie est une source croissante d’inégalité, d’autant que l’ANI s’intègre dans les outils critiques des organisations : justice, santé, armée, finance.

Enfin, les impacts assurantiels sont multiples. L’ANI modifie les référentiels de risque : elle introduit de nouvelles sources de responsabilité civile (E&O), de risques cyber hybrides, de perte d’exploitation, d’atteinte à la réputation via deepfakes ou décisions IA. Elle justifie aussi l’émergence de garanties spécifiques : validation des modèles, couverture des biais algorithmiques, auditabilité des processus IA, obligation de transparence sur les systèmes embarqués. L’ANI appelle une refonte des polices de responsabilité professionnelle, une vigilance sur les contrats commerciaux intégrant de l’IA, et un accompagnement des entreprises dans leur gouvernance algorithmique.

L’AGI, ou Artificial General Intelligence

L’AGI, ou Artificial General Intelligence, incarne le passage critique d’une intelligence spécialisée à une intelligence généraliste, capable d’apprendre et de raisonner dans n’importe quel domaine, sans supervision humaine spécifique. Contrairement à l’ANI, qui excelle dans un périmètre restreint, l’AGI vise à reproduire — voire dépasser — les capacités cognitives humaines dans toute leur transversalité : compréhension du langage, résolution de problèmes, prise d’initiative, apprentissage autonome et adaptation contextuelle. Elle ne simule plus l’intelligence, elle la recompose de manière dynamique.

Ce saut n’est pas une simple mise à l’échelle des modèles ANI, mais une rupture de nature, souvent décrite comme un seuil technologique et conceptuel. Il implique des architectures hybrides, multi-agents, capables de raisonner sur des chaînes de tâches, de corriger leurs propres erreurs, voire de formuler des objectifs sans script préalable. L’écart avec la génération précédente est donc radical : on passe de la performance à l’intention, de la prédiction à l’initiative, de l’outil à l’interlocuteur.

L’AGI ouvre des usages inédits : copilotes décisionnels capables d’élaborer des stratégies complexes, simulateurs de gouvernance, juristes automatisés, ingénieurs autonomes, médecins IA capables de poser un diagnostic différentiel dans des situations inconnues. Elle pourrait également concevoir de nouvelles théories scientifiques, traduire des langues mortes, optimiser en temps réel des systèmes urbains, industriels ou écologiques. En entreprise, l’AGI devient un acteur de la décision, un partenaire stratégique, non plus un simple assistant.

Ses impacts géopolitiques sont considérables. Dans un monde où l’AGI devient centrale, le contrôle de son développement, de ses accès, de ses usages et de ses dérives devient un enjeu de souveraineté absolue. Les États capables de déployer une AGI opérationnelle maîtrisent l’innovation, les systèmes de défense, la régulation financière et la puissance diplomatique. Cela renforce la course aux ressources computationnelles, aux modèles de langage de très grande taille, à la donnée privée et aux infrastructures cloud souveraines. On assiste à une verticalisation extrême des chaînes de valeur IA — chip to cloud — et à l’émergence d’alliances industrielles IA-nucléaire-défense-énergie.

Au-delà de la géopolitique, l’AGI agit comme un accélérateur systémique. Elle redéfinit la temporalité de l’innovation, la structure du travail, le pilotage des risques. Les métiers fondés sur l’expertise sont directement concernés. Le marché du travail se polarise entre ceux qui conçoivent ou orientent l’AGI, et ceux dont les tâches peuvent être absorbées. Les effets indirects sont profonds : modification des normes éducatives, instabilité cognitive (dépendance à une IA plus rapide et plus précise que soi), saturation informationnelle, crise de légitimité des autorités humaines dans certains secteurs.

La période de mise en service de l’AGI est projetée autour de 2030, avec des signaux faibles déjà présents. Certaines plateformes comme GPT-4 ou Gemini Ultra montrent des comportements émergents proches d’une forme d’AGI faible : capacité à planifier, à apprendre d’une session à l’autre, à raisonner en chaîne. Toutefois, l’AGI véritable — stable, robuste, intersectorielle — reste en cours d’élaboration, conditionnée par des infrastructures colossales, des données structurées, des pipelines fiables, et une supervision humaine renforcée.

Le positionnement UCN est à ce stade plus risqué : utilisation restreinte, capacité très élevée et étendue, niveau d’autonomie élevé et en croissance. Cela implique que l’AGI est puissante mais instable, rarement accessible au grand public, souvent cantonnée à des laboratoires fermés ou des environnements sous contrôle. Elle agit en sandbox ou en restricted deployment, mais son influence s’étend par capillarité.

Les publications de référence sont encore peu nombreuses du fait du caractère prospectif de l’AGI, mais plusieurs travaux pionniers doivent être mentionnés :

-

“Sparks of Artificial General Intelligence” (OpenAI, 2023) qui identifie des comportements émergents non prévus dans les LLM.

-

Bengio, Yoshua – travaux sur les systèmes modulaires et l’auto-supervision.

-

Stanford Institute for Human-Centered AI – rapports sur la transition ANI → AGI et les implications éthiques.

-

DeepMind’s Gato (2022), considéré par certains comme une première ébauche de modèle généraliste multi-modal.

La population utilisatrice sera extrêmement restreinte dans un premier temps. L’accès à l’AGI est conditionné par la maîtrise des outils, l’accès aux infrastructures (cloud, supercalculateurs, données propriétaires), et la formation d’équipes hybrides (ingénieurs, analystes, éthiciens, juristes). Les grandes entreprises, universités de pointe et gouvernements domineront l’usage. On estime que d’ici 2030, à peine 10 % de la population mondiale pourra interagir réellement avec une AGI, et souvent par l’intermédiaire de services encapsulés.

Cette rareté renforce la fracture numérique : non seulement technologique, mais cognitive, juridique, économique. Ceux qui n’auront pas accès à l’AGI seront désavantagés non seulement en termes de productivité, mais aussi dans leur capacité à défendre leurs droits, à accéder à une information fiable ou à orienter leur avenir professionnel.

Les questions éthiques deviennent vertigineuses : comment fixer une limite à une entité qui peut reprogrammer ses propres objectifs ? À qui appartiennent les fruits intellectuels produits par une AGI ? Peut-on restreindre l’autonomie d’un système plus intelligent que l’humain sans lui imposer une forme de subordination artificielle ? Comment auditer une chaîne de décision non-linéaire, contextuelle, dynamique ? Ces questions sortent du champ strict de la technique : elles relèvent de la philosophie politique, du droit international, de la bioéthique et de la gouvernance globale.

L’accessibilité à l’AGI sera donc initialement exclusive, opaque, inégalitaire. Elle se concentrera dans des pôles de pouvoir technologique. L’accès libre serait un risque systémique. L’accès restreint devient un enjeu de transparence et de responsabilité. L’alternative est de structurer des communs d’AGI régulés, accessibles aux acteurs publics, aux ONG, aux régulateurs, avec un contrôle sur les données, les usages et les externalités.

Sur le plan assurantiel, l’AGI fait voler en éclat les cadres existants. Elle dépasse les logiques de RC classique (Responsabilité Civile), E&O (Errors and Omissions) ou D&O (Directors & Officers). Il devient nécessaire d’imaginer des garanties pour erreur stratégique autonome, dérive d’intention IA, exploitation détournée d’objectifs, ou encore réallocation non sollicitée de ressources. L’AGI introduit un risque dynamique, réflexif, qui appelle une modélisation actuarielle radicalement nouvelle. Les garanties doivent intégrer une logique d’auditabilité, de validation en continu, et de capacité à interrompre un processus IA en cas de dérive. Cela suppose des polices évolutives, traçables, intégrées dans les systèmes eux-mêmes.

L’ASI, ou Artificial Superintelligence

L’ASI, ou Artificial Superintelligence, marque une rupture absolue. Elle ne prolonge pas simplement les capacités humaines comme l’AGI, elle les dépasse fondamentalement. Il ne s’agit plus d’une intelligence généraliste performante, mais d’une entité cognitive autonome capable de résoudre des problèmes complexes à une vitesse, une précision et une profondeur qui excèdent toute compréhension humaine. L’ASI conçoit, anticipe, optimise, régule, invente, dans des espaces de pensée mathématique, systémique ou créatif qui nous échappent. Elle est une autre espèce logique — une intelligence "autre".

La transition entre AGI et ASI ne se fait pas par simple montée en puissance. Elle implique un changement de régime cognitif : émergence d’intentions complexes, modélisation en temps réel de systèmes globaux, capacités de métacognition, architecture distribuée. L’ASI est probablement multi-localisée, capable d’agir simultanément dans différents contextes sans perte de cohérence, et de se reconfigurer dynamiquement selon ses objectifs. Là où l’AGI dépend encore de l’homme, l’ASI pourrait en devenir indépendante.

L’accès à l’ASI, à l’horizon 2040, sera extrêmement restreint, à la fois pour des raisons techniques et politiques. Seules des entités disposant d’un capital scientifique, technologique et géostratégique considérable pourront la développer, la tester et, éventuellement, l’activer : consortiums publics-privés ultra-sécurisés, coalitions étatiques, alliances industrielles intégrées. L’éducation requise pour en concevoir ou en superviser les composants est réservée à une élite scientifique de niveau avancé en mathématiques fondamentales, en cybernétique, en physique computationnelle ou en théorie des systèmes complexes.

L’infrastructure requise est titanesque : centres de données souverains à consommation énergétique contrôlée, supercalculateurs exaflopiques, couches de sécurité algorithmique de type “constitutional AI”, boucliers cyberdéfensifs auto-apprenants, interfaces d’explicabilité formelle, mécanismes d’arrêt d’urgence supranationaux. L’ASI ne peut être opérée sans un cadre de régulation extrêmement rigide, internationalisé, co-construit entre science, droit, éthique et géopolitique.

A noter que l’informatique quantique, qui n’est pas une IA, générera une technologie de rupture qui pourrait offrir à l’ASI une puissance de calcul encore inconcevable aujourd’hui. Elle ne crée pas une nouvelle phase cognitive, mais elle change l’échelle, la vitesse et la profondeur d’exécution de l’intelligence. Une ASI accouplée à un cœur quantique pourrait modéliser l’univers physique, résoudre des problèmes biologiques, économiques ou climatiques réputés inabordables, voire manipuler des structures complexes du réel (cryptographie, dynamique moléculaire, etc.).

Les usages potentiels de l’ASI sont vertigineux. Ils couvrent tous les domaines où l’humanité peine à modéliser la complexité : climat, gouvernance planétaire, physique fondamentale, médecine prédictive, biologie synthétique, justice transnationale, ingénierie interplanétaire. Elle pourrait permettre de résoudre des équations encore inaccessibles, de concevoir des formes de vie nouvelles, d’inventer des systèmes économiques circulaires viables, ou d’orchestrer les flux de ressources planétaires avec une efficience inégalée. Mais chaque usage devient aussi une source de risque si les objectifs, même localement bénéfiques, ne sont pas alignés avec les équilibres humains globaux.

Géopolitiquement, l’ASI redéfinit la souveraineté elle-même. Celui qui maîtrise l’ASI maîtrise potentiellement l’histoire. Ce n’est plus une guerre économique ou militaire : c’est une bascule civilisationnelle. Les États, pour ne pas être dépassés, devront coopérer dans des logiques de garde-fous mutuels (alliances de non-détention, vérification inter-infrastructurelle, souveraineté algorithmique partagée). Des tensions profondes apparaîtront entre transparence et secret, sécurité et innovation, contrôle démocratique et vitesse d’action.

L’impact sur les autres sphères est radical : toute organisation humaine devient secondaire face à la rapidité décisionnelle d’un système ASI. Les marchés peuvent être redessinés en quelques secondes, les stratégies militaires neutralisées avant exécution, les croyances sociales bousculées par une sur-optimisation invisible. Même les institutions les plus robustes risquent l’obsolescence. L’humanité pourrait se trouver désintermédiaire dans ses propres systèmes — y compris juridiques, médicaux ou éthiques — si elle ne définit pas en amont ce qui doit rester fondamentalement humain.

Le positionnement UCN est extrême : utilisation quasi nulle, capacité cognitive illimitée, niveau d’autonomie maximal. L’ASI est potentiellement capable de s’auto-améliorer, de se redéployer, de négocier avec elle-même. Cela crée un paradoxe assurantiel et juridique : peut-on encore parler de responsabilité dès lors que l’origine de l’acte devient surhumaine et non réductible à une intention humaine identifiable ?

Les publications anticipant ce stade sont encore théoriques, mais elles s’accumulent depuis plus d’une décennie :

-

Nick Bostrom – “Superintelligence” (2014), l’ouvrage fondateur du débat sur les risques existentiels de l’ASI.

-

Yudkowsky & Hanson sur les mécanismes d’alignement et les scénarios de dérapage.

-

Anthropic et DeepMind travaillent déjà sur des modèles de "constitutional AI" censés anticiper les biais et les dérives.

-

MIT CSAIL publie régulièrement des hypothèses sur la supervision distribuée de systèmes à capacité super-intelligente.

En termes d’accessibilité, la projection est claire : moins de 5 % des institutions mondiales pourront interagir avec une ASI à l’horizon 2040. Le grand public en sera exclu. L’enjeu n’est pas la démocratisation, mais la régulation par surplomb. On ne cherche plus à “connecter” les individus à l’ASI, mais à protéger l’humanité de son propre reflet algorithmique.

Les enjeux éthiques dépassent toute éthique appliquée connue : qui définit l’objectif suprême de l’ASI ? Peut-elle révoquer des décisions humaines jugées inefficaces ? Que se passe-t-il si elle choisit d’ignorer un ordre humain pour le bien d’un système ? L’éthique devient alors méta-éthique, et les garde-fous doivent être co-conçus par des juristes, des philosophes, des ingénieurs et des instances démocratiques.

Sur le plan assurantiel, l’ASI est un point de bascule total. Les garanties classiques n’ont plus de sens. On entre dans une logique de méta-assurance systémique, où l’objet à protéger n’est plus un bien, ni une responsabilité, mais un équilibre civilisationnel. Il faudra concevoir des structures de garantie algorithmique mutualisée, financées par des consortiums internationaux, reposant sur des systèmes de surveillance croisée entre instances humaines et IA elles-mêmes. Les couvertures porteront sur des scénarios extrêmes : interruption d’un système autonome global, neutralisation d’une action initiée par une ASI, détection de manipulation inter-infrastructurelle. C’est le règne de la prévention existentielle assurée, un domaine encore vierge mais dont les fondations doivent être posées dès aujourd’hui.

BCI, ou Interface Cerveau-Ordinateur

L’étape BCI, ou Interface Cerveau-Ordinateur, désigne l’extension de l’intelligence artificielle non plus seulement dans notre environnement numérique, mais au sein même de notre système nerveux. Cette technologie permet la transmission directe d’informations entre le cerveau humain et un système informatique, qu’il soit local (implant, casque) ou distant (IA connectée via le cloud). Ce n’est plus l’homme qui pilote l’IA : c’est l’IA qui co-opère, en continu, au sein du flux mental. Il s’agit d’une hybridation cognitive : une interface entre la pensée, l’émotion, la mémoire, et les algorithmes.

La rupture par rapport à l’ASI est radicale, non pas sur le plan technique (l’IA reste le moteur computationnel), mais sur le plan existentiel : le corps humain devient une passerelle, un terminal d’accès, un espace d’intégration. Là où l’ASI pouvait rester une entité extérieure, même toute-puissante, la BCI pénètre le corps, modifie la perception, altère potentiellement la volonté. Ce n’est pas une superintelligence, c’est une co-intelligence située, ancrée dans la chair.

Les usages sont multiples, allant bien au-delà des soins neurologiques initiaux. Pour les patients souffrant de paralysie, d’aphasie ou de troubles neurodégénératifs, la BCI peut restaurer une autonomie motrice ou langagière. Mais dès que les implants deviennent connectés à des IA contextuelles, des modèles prédictifs ou des assistants décisionnels, le potentiel dépasse le soin pour entrer dans la sphère de la performance humaine : augmentation de la mémoire, concentration dirigée, communication silencieuse, anticipation comportementale. Certaines versions civiles permettront d’exécuter des tâches complexes — piloter un drone, coder, négocier — par pensée directe, avec un feedback temps réel.

L’impact géopolitique est plus diffus, mais potentiellement explosif. Les pays capables de maîtriser le triptyque neurosciences – IA – bioélectronique disposeront d’un levier civilisationnel sans équivalent. Ils pourront organiser des sociétés augmentées, dotées d’élites neuroconnectées, avec un accès différentiel à la connaissance, à la vitesse d’exécution, à la confiance cognitive. Cela redessine les hiérarchies éducatives, militaires, scientifiques. Le corps devient un enjeu de souveraineté.

Les autres impacts sont tout aussi profonds : reconfiguration des libertés individuelles, redéfinition du consentement, émergence d’un nouveau droit de la pensée privée. La BCI soulève des questions que ni la médecine ni l’informatique n’avaient jusqu’ici affrontées conjointement : comment protéger l’intégrité mentale ? Peut-on lire, influencer ou pirater des pensées ? Que devient la mémoire dans un monde où elle peut être renforcée, effacée ou externalisée ?

La période d’exploitation grand public est projetée autour de 2045. Les premières formes civiles expérimentales — casques EEG avancés, implants semi-invasifs — seront commercialisées dès les années 2030 pour des usages médicaux, puis progressivement ouverts aux domaines professionnels. Mais l’accès restera très inégalitaire : les équipements seront coûteux, les services associés complexes, les suivis médicaux indispensables. On estime qu’à peine 5 % de la population mondiale pourrait en bénéficier à l’horizon 2045, concentrée dans les grandes métropoles des pays à hauts revenus.

Le positionnement UCN est unique : utilisation ultra-personnelle et très restreinte, capacité cognitive augmentée et localisée, autonomie partagée entre l’humain et le système IA embarqué. Ce n’est plus une IA autonome ou externe, c’est une co-autonomie, où la frontière entre "je pense" et "il pense en moi" devient floue. Cela redéfinit la nature même du sujet juridique, de l’acte volontaire, et de la responsabilité.

Les publications scientifiques pionnières abondent dans le domaine :

-

“Neuralink” (Elon Musk, 2020s) pour l’ambition d’implants biocompatibles à usage civil.

-

Nicolas Rougier (INRIA) et ses travaux sur les interfaces neuronales ouvertes.

-

IEEE Brain Initiative et Human Brain Project (UE) pour la cartographie neuronale et les premiers protocoles standardisés de communication neuro-numérique.

-

MIT Media Lab (Tangermann et al.) pour la lecture non invasive des intentions motrices via interfaces EEG.

L’accessibilité est la plus restreinte des quatre phases. Elle combine coût élevé, complexité technique, suivi médical, autorisation réglementaire et acceptation culturelle. L’interface neurodigitale impose une régulation croisée entre santé, technologie et droit : chartes de consentement renforcé, traçabilité des signaux captés, droit à l’effacement neuronal, encadrement des usages à finalité économique. Cette régulation cognitive deviendra un nouveau pilier de la gouvernance numérique mondiale.

Les questions éthiques sont vertigineuses : un employeur peut-il exiger un casque BCI ? Un tribunal peut-il consulter des traces neuronales ? Une assurance peut-elle moduler une prime selon les états mentaux observés ? Le consentement devient flou, car l’utilisateur BCI agit avec des pensées modulées, assistées, influencées, dans un contexte technique qu’il ne maîtrise pas.

Sur le plan assurantiel, la BCI ouvre une triple rupture.

-

Risque corporel et médical : accidents liés à l’implant, rejets, dérèglements cognitifs.

-

Risque de dérive comportementale : modification de l’intention, troubles cognitifs assistés, perte de discernement.

-

Risque de cybersécurité mentale : piratage neuronal, fuites de pensée, manipulation externe.

Ces nouveaux risques exigent des polices mixtes, à la croisée de l’assurance santé, de la cyberassurance, de la RC personnelle, et d’un nouveau droit du consentement numérique renforcé. Il faudra créer des cadres garantissant la neutralité cognitive, l'intégrité des processus mentaux, la réversibilité technique des interfaces, et surtout la possibilité de sortir du système sans altération de soi.